Cet article a été écrit par Alexandre LE BOUCHER pour compléter son excellente série d’infographies destinée à nous aider à repérer nos biais et nous donner quelques astuces pour les limiter au cabinet. Si vous n’avez pas déjà vu cette série sur les réseaux sociaux ou bien dans notre rubrique infographies, vous les trouverez à la toute fin de ce billet. Bonne lecture.

Biais au cabinet

La notion biais cognitif est un terme introduit par deux psychologues et prix Nobel d’économie, D. Kahneman et A. Tversky au début des années 1970. Ce terme de biais cognitif désignait la tendance de l’esprit humain à prendre des décisions irrationnelles dans le domaine qu’ils étudiaient : l’économie.

Le terme a légèrement changé de signification depuis, et Haselton, Nettle et Murray proposent une définition telle que : « Les cas où la cognition humaine produit de manière fiable des représentations qui sont systématiquement déformées par rapport à un aspect de la réalité objective. » [1]. Une autre définition apportée est que les biais cognitifs sont des modèles de déviation systématique de la norme ou de la logique dans le processus de jugement [2].

Il existerait jusqu’à 180 biais cognitifs que Buster Benson a séparé en 4 catégories : Réagir rapidement ; Traiter beaucoup d’informations ; Mémorisation de ces informations ; Donner un sens à une situation [3]. John Manoogian a repertorié tous ces biais cognitif dans « The cognitive bias codex : A Visual Of 180+ Cognitive Biases » [4].

En plus des biais cognitifs, il existe ce que l’on nomme les heuristiques de jugement. L’heuristique de jugement est une méthode de raisonnement où l’on réalise des opérations mentales automatiques, intuitives et rapides. Certaines heuristiques peuvent alors parfois favoriser l’expression de biais cognitif.

Comme on l’a défini, les biais cognitifs et les traits de personnalité peuvent affecter nos processus de raisonnement clinique, ce qui peut conduire à des erreurs dans le diagnostic, la gestion ou le traitement des affections médicales. [5]

Une revue systématique publiée en 2016 : « Cognitive biases associated with medical decisions : a systematic review » [6] a eu pour but de déterminer les biais cognitifs les plus communs responsables de prises de décision clinique chez les médecins, ainsi que de déterminer l’influence des biais cognitifs dans la précision d’un diagnostic, et de ce fait l’utilisation à tort de certaines ressources liées à celui-ci.

Cette revue systématique a mis en évidence que les biais cognitifs pouvaient affecter un large éventail de médecins et influencent le diagnostic, l’exactitude, la gestion et les décisions thérapeutique. Cependant, du fait de la grande hétérogénéité des études incluses, la prévalence réelle reste inconnue.

Le but ici sera d’établir une liste non-exhaustive de biais cognitif et d’heuristique de jugement que l’on serait amenés à rencontrer dans notre pratique quotidienne. Par la suite, nous tenterons de donner des pistes afin de les éviter. Car il ne suffit pas de connaitre l’existence d’un biais pour s’en prémunir, malgré ce que pouvait écrire Tversky A, Kahneman D. dans « Judgement under uncertainty: heuristics and biases. Science » (1974) : « La prise de conscience de ces biais aide à les éviter » [7]. Cependant, il ne connaissait pas l’existence du biais de la tâche aveugle mis en lumière en 2002 par Émilie Pronin et ses collègues. Ils ont mené 3 études visant à démontrer l’impact du biais du point aveugle (ou de la tache aveugle) [8].

Biais du point aveugle

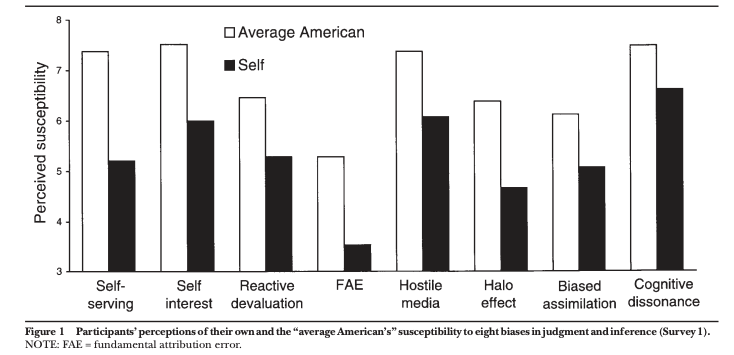

Dans leur première recherche, il a été demandé aux participants (24 étudiants en psychologie de l’université de Stanford) d’indiquer dans quelle mesure eux-mêmes, et l’Américain moyen, présentaient huit biais spécifiques qui avait été bien documentés dans des recherches préalables.

Dans une deuxième étude, il a été demandé aux participants (les mêmes que pour l’étude 1) d’évaluer leur susceptibilité à divers biais par rapport à celle de leurs camarades de promotion, une cible de comparaison moins hypothétique et plus pertinente pour les participants que l’Américain moyen.

La troisième enquête portait à la fois sur une population plus diversifiée (les voyageurs du principal aéroport desservant la région de la baie de San Francisco) et sur un ensemble de biais plus variés, c’est-à-dire des biais dont les auteurs avaient supposé qu’ils varieraient considérablement en fonction du niveau social et de la disposition intellectuelle de la personne concernée.

Les résultats de ces trois études suggèrent que la connaissance de certains biais dans le jugement humain, et la capacité à reconnaître l’impact de ces biais sur les autres, n’empêche pas d’y succomber et ne fait pas prendre conscience de l’avoir fait. En effet, les participants à ces différentes études ont nié que les évaluations de leurs qualités personnelles (étude 2) et leurs attributions pour un succès ou un échec particulier (étude 3) aient été biaisées même après avoir fait apparaître les biais en question et en avoir lu les descriptions.

Figure extraite de l’étude 1 de Pronin, E., Lin, D. Y., & Ross, L. (2002). The Bias Blind Spot: Perceptions of Bias in Self Versus Others. Personality and Social Psychology Bulletin, 28(3), 369–381 [9]

Première infographie

Subjectivité de l’enquêteur / Effet de primauté et de récence / Biais d’auto-complaisance

Biais de subjectivité de l’enquêteur (wording effect)

L’effet de formulation (wording effect) décrit les effets possibles sur les participants causés par l’ordre des mots présentés, ou même le choix des mots eux-mêmes.

Lorsque le thérapeute interroge un patient en lui suggérant des réponses qui vont dans le sens de ses convictions, l’insistance plus ou moins prononcée sur la recherche d’une amélioration (ou du moins d’un changement) peut très certainement influencer les réponses.

Pour l’éviter

Poser des questions ouvertes ou avec toutes les possibilités « C’est pareil, moins bien ou mieux » ?

Biais d’auto-complaisance

La première expérience démontrant l’existence de ce biais date de 1954 [9]. L’expérience a été réalisée avec des enseignants, qui devaient déterminer si la réussite de leurs élèves était due davantage aux compétences et aux efforts des enfants, ou à leurs propres compétences pédagogiques.

Les résultats de cette expérience ont mis en évidence la tendance qui consiste à s’attribuer les succès et à attribuer les échecs à des personnes ou à des choses extérieures. Ainsi, si l’enfant a réussi, les enseignants ont eu tendance à s’attribuer le mérite de cette réussite. En revanche, si l’enfant était en situation d’échec, les enseignants avaient tendance à lui en vouloir.

En 1975 cette fois, l’expérience a été menée avec des élèves. Ils devaient déterminer si leur degré de réussite était davantage dû à eux-mêmes, à leurs efforts ou à leur professeurs. Les résultats mettent encore en évidence un « biais d’auto-complaisance ». En d’autres termes, si l’enfant réussit, il aura tendance à s’attribuer le mérite de cette réussite. En revanche, si l’enfant échoue, il sera plus enclin à blâmer son enseignant.

Dans le cadre de notre pratique clinique, le biais d’auto-complaisance consiste donc à s’attribuer les réussites et considérer que les échecs sont du fait du patient ou de choses extérieures. Il est probable que lorsque un de nos traitements échoue, nous attribuerons la faute au patient qui n’aurait pas fait ses exercices, plutôt qu’à remettre en question le traitement. Et inversement si un patient va mieux, c’est grâce au traitement qu’il a reçu. Il est possible que ce soit le cas néanmoins, une multitude de facteurs peuvent jouer dans l’amélioration du patient (la régression vers la moyenne par exemple).

Effet de primauté ou de récence

L’effet de primauté désigne la facilité à se rappeler la première information communiquée, et l’effet de récence désigne la capacité à se rappeler du dernier élément. Ces effets sont valables à la fois pour le thérapeute lors du bilan, et pour le patient lors des séances [10]. Ces effets de primauté et de récence ont été associés à l’activité neuronale pendant la phase de mémorisation. Même s’il semble que les mécanismes neuronaux soient différents entre les deux, des chercheurs ont identifié des corrélations entre ces effets et la mémorisation sur l’activité neuronale enregistrée en magnéto-encéphalographie continue [11].

Comment l’éviter ?

Prendre des notes, résumer les dires du patient pour qu’il confirme ou élabore plus, et lui demander de nous répéter ce qu’il a retenu de la séance.

Il peut aussi être intéressant d’utiliser ce biais cognitif ! En effet, donner les messages clés au début et à la fin des séances permettrait ainsi une meilleure mémorisation des informations essentielles.

Références

[1]Haselton MG, Nettle D, Murray DR. The Evolution of Cognitive Bias. In: The Handbook of Evolutionary Psychology [Internet]. Hoboken, NJ, USA: John Wiley & Sons, Inc.; 2015. p. 1–20. doi:10.1002/9781119125563.evpsych241

[2] Haselton MG, Nettle D, Andrews PW (2005). « The evolution of cognitive bias. » The Handbook of Evolutionary Psychology. Hoboken, NJ, US: John Wiley & Sons Inc. pp. 724–746.

[3] 25 biais cognitifs qui nuisent à la pensée rationnelle. (2015, février 22). Consulté à l’adresse http://www.psychomedia.qc.ca/psychologie/biais-cognitifs

[4] The Cognitive Bias Codex – 180+ biases, designed by John Manoogian III

[5] Croskerry P. The importance of cognitive errors in diagnosis and strategies to minimize them. Acad Med. 2003;78(8):775–80

[6] Saposnik et al. Cognitive biases associated with medical decisions: a systematic review. BMC Medical Informatics and Decision Making (2016) 16:138 doi:10.1186/s12911-016-0377-1

[7] Tversky A, Kahneman D. Judgement under uncertainty: heuristics and biases. Science. 1974; 186:1124–31.

[8] Pronin, E., Lin, D. Y., & Ross, L. (2002). The Bias Blind Spot: Perceptions of Bias in Self Versus Others. Personality and Social Psychology Bulletin, 28(3), 369–381.

[9] Johnson, TJ, Feigenbaum, R., & Weiby, M. (1964). Some determinants and consequences of the teacher’s perception of causation. Journal of Educational Psychology, Vol 55 (5), Oct 1964, 237-246.

[10] Crano, W. D. (1977). Primacy versus Recency in Retention of Information and Opinion Change. The Journal of Social Psychology, 101(1), 87–96.

[11] Stephane, M., Ince, N. F. et al. (2010). Neural oscillations associated with the primacy and recency effects of verbal working memory. Neuroscience Letters, 473(3), 172–177.

Deuxième infographie

Biais de corrélation illusoire / Post hoc ergo propter hoc / Cum hoc ergo propter hoc / Biais de confusion

Biais de corrélation illusoire

Le terme « corrélation illusoire » est proposé par L. J. Chapman en 1967. Il désigne le constat, par les observateurs, d’une corrélation entre deux classes d’événements qui, en réalité, (a) ne sont pas corrélées, ou (b) sont corrélées dans une moindre mesure que ce qui est rapporté, ou (c) sont corrélées dans la direction opposée à celle qui est rapportée [1]. Dans les essais thérapeutiques, une corrélation illusoire et une fausse causalité peuvent conduire à un rejet incorrect de l’hypothèse nulle (une erreur de type I ou « faux positif ») [2]. Lorsque deux variables sont corrélées, cela peut être pour plusieurs raisons :

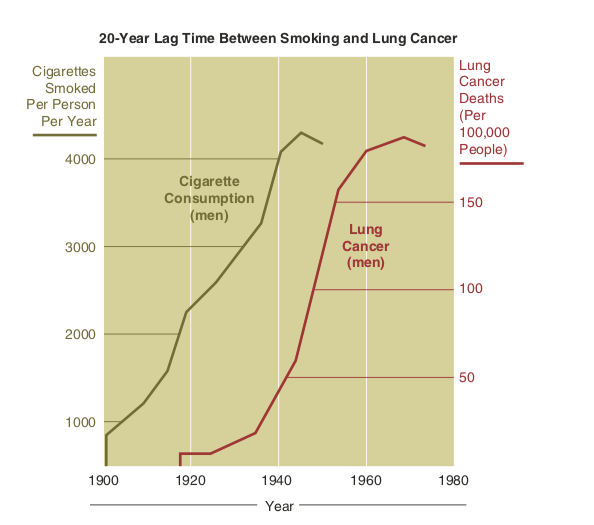

- X cause Y (vraie corrélation) : Quelques fois, un évènement survient juste après un autre et cela par causalité. Par exemple, la consommation de cigarette peut provoquer un cancer des poumons.

True causation. (Sakurambo. Cancer smoking lung cancer correlation from NIH [Image file]. In: Wikimedia commons. 2007. Retrieved from https://commons.wikimedia.org/wiki/File:Cancer_smoking_lung_cancer_correlation_from_NIH.svg.)

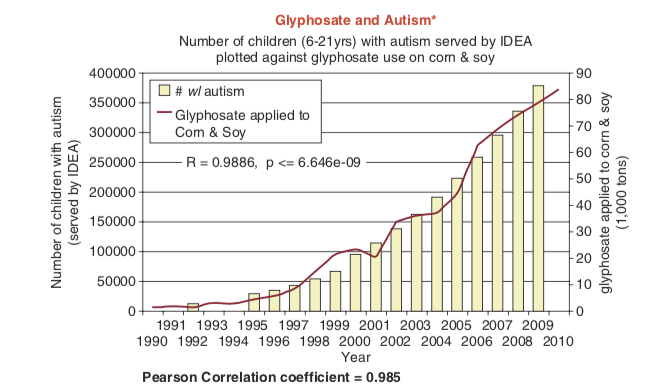

- X et Y sont corrélés par coïncidence : Parfois, X et Y sont liés par pur hasard. Lorsque l’on présente des variables qui semblent être fortement corrélées, il peut être difficile de distinguer lesquelles de ces relations existent. Par exemple, il existe une corrélation entre utilisation du Glyphosate et apparition de l’autisme (Pearson correlation coeff = 0,985) [3].

Les taux d’autisme ont augmenté en même temps que l’utilisation du glyphosate. (Honeycutt Z. Swanson charts: Glyphosate and GMOs linked to neurological disorders and more [Image file, Blogpost]. Moms across America. 2014. Retrieved from https://www.momsacrossamerica.com/ glyphosate_linked_to_neurological_disorders.)

Post hoc ergo propter hoc

« juste après donc conséquence de ». C’est le fait d’attribuer un lien de causalité à deux éléments qui se succèdent.

Cum hoc ergo propter hoc

« avec ceci, donc à cause de ceci ». C’est le fait d’attribuer un lien de causalité à deux éléments en corrélation.

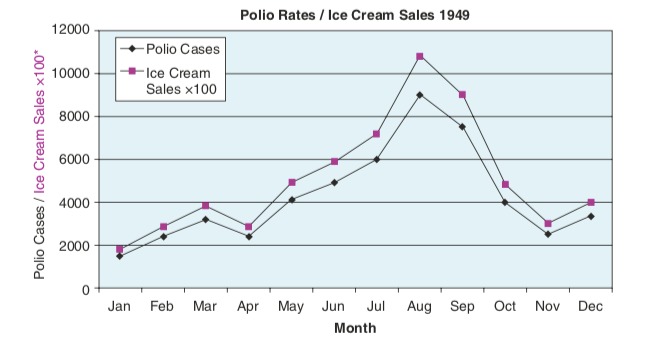

- X et Y peuvent apparaître corrélés lorsqu’ils sont tous deux causés par un troisième facteur, Z. Par exemple, au plus fort de l’épidémie de poliomyélite, certains scientifiques ont pensé que la consommation de glaces influait sur la survenue de la maladie. Ceci en notant que plus les ventes de glaces augmentaient, plus les taux de polio augmentaient. La cause commune de ces deux phénomènes était l’été, qui augmentait à la fois les ventes de glaces et les possibilités de transmission de la polio [4]. L’été est donc un facteur de confusion.

L’été a permis d’augmenter les ventes de glaces et le nombre de cas de polio. (Herrell H. How do I know if a study is valid? [Image file]. Howardisms.com. (n.d.). Retrieved Sept 15, 2018 from http://www.howardisms.com/evidence-based-medicine/how-do-i-know-if-a-study-is-valid/.)

Biais de confusion

Le biais de confusion désigne un ensemble d’erreurs qui peuvent survenir dans l’interprétation des liens entre plusieurs variables. Dans le cadre d’une pratique courante, ces variables peuvent être l’évolution naturelle de la maladie, l’effet contextuel, la régression à la moyenne [5].

Prenons un exemple pour illustrer ce biais. La lombalgie commune aiguë est une affection assez fréquemment rencontrée dans les cabinets de kinésithérapie. Néanmoins, celle-ci évolue favorablement dans 90% des cas en moins de 4 à 6 semaines [6]. Il est possible qu’un patient arrive dans votre cabinet entre le début des symptômes et cette période d’évolution de 4 à 6 semaines. Dans ce cas, un traitement X ou Y pourrait paraître efficace alors que, sans celui-ci, le résultat aurait été similaire. Dans ce cas la variable de confusion est l’évolution spontanée de la maladie.

Comment les éviter ?

Demandez-vous si certains cas ne correspondent pas à vos corrélations supposées. Une façon simple de le faire est de consigner par écrit les événements que vous croyez être corrélés, en vous assurant que tous les cas pertinents sont notés. [7] Une autre manière de faire, lorsque vous avez des doutes, pourrait être d’utiliser avec vos patients des applications ou journaux pour suivre leurs symptômes. Par exemple Migraine Buddy ou Manage My Pain sont des outils gratuits en français. Avant de conseiller une application, assurez-vous de la sécurité des données de vos patients. [8] Utilisez bien ces journaux avec parcimonie, nous ne savons pas quels sont les risques qu’ont les patients à se concentrer sur leurs symptômes dans la journée. Il est plausible que cela augmente les risques de ruminations et d’hypervigilance, ce qui est peut-être néfaste.

Il existe une liste de critères de causalité afin d’attribuer une causalité à des éléments en corrélation, il s’agit des critères de Bradford Hill [9]. Ces critères ne sont pas très récents et ont donc, pour certains, une relative utilité. Notez bien que même l’auteur ne conseille pas d’utiliser ces critères comme une check-list [10]. Si tous les critères sont négatifs, il est toujours possible qu’un lien de causalité existe, c’est juste moins probable. À l’inverse, même si tous les critères sont positifs, il est possible qu’un facteur de confusion se glisse dans l’affaire.

- Force de l’association : plus les effets liés à l’association sont larges, plus un lien causal est probable. Un faible effet n’implique toutefois pas une absence de lien de causalité.

- Stabilité de l’association : La corrélation doit être reproductible. Exemple, si un mouvement a aboli les douleurs, il doit pouvoir l’abolir à nouveau.

- Spécificité : La même thérapie n’est pas souvent efficace sur tout. Ex : les mouvements répétés utilisés pour traiter les douleurs, les acouphènes, les problèmes urinaires,…

- Relation temporelle : L’exposition à l’élément supposé causal doit survenir avant l’événement qui nous intéresse, sauf s’il s’agit d’une cause secondaire. Ex : la perturbation du sommeil avant une douleur, ou une aggravation.

- Relation dose-effet : Une plus grande dose mène à un plus gros effet. Par exemple, plus on reproduit un mouvement censé améliorer les douleurs, plus l’amélioration doit être grande.

- Plausibilité : S’il y a un mécanisme biologique capable d’expliquer la présentation clinique, cela est légèrement en faveur de la relation de causalité.

- Preuve expérimentale : La présence de preuves dans la littérature en faveur de ce lien augmente la probabilité de causalité.

- Analogie : Connaissance de phénomènes similaires.

Références

[1] Chapman, L. J. (1967). Illusory correlation in observational report. Journal of Verbal Learning and Verbal Behavior, 6(1), 151–155.

[2] Howar, J. Illusionary Correlation, False Causation, and Clustering Illusion in : Cognitive Errors and Diagnostic Mistakes: A Case-Based Guide to Critical. Springer International Publishing. 1st ed. 2019. P 265 – 283.

[3] Honeycutt Z. Swanson, H. (2014, janvier 20). Swanson Charts: Glyphosate and GMOs linked to Neurological Disorders and More. Consulté à l’adresse https://www.momsacrossamerica.com/glyphosate_linked_to_neurological_disorders

[4] Herrell, H., MD. (2016, août 19). How Do I Know If A Study Is Valid? Consulté à l’adresse http://www.howardisms.com/evidence-based-medicine/how-do-i-know-if-a-study-is-valid/

[5] Patrick Mismetti, Silvy Laporte . Méthodologie des essais cliniques : pourquoi et pour qui ? Les notions essentielles à une lecture critique . Médecine thérapeutique. 2003;9(3):68-72.

[6] Haute Autorité de Santé. Prise en charge du patient présentant une lombalgie commune. Saint-Denis La Plaine: HAS; 2019.

[7] Klein, J. G. (2005). Five pitfalls in decisions about diagnosis and prescribing. BMJ, 330(7494), 781–783. doi:10.1136/bmj.330.7494.781

[8] Minen MT, Stieglitz EJ, Sciortino R, Torous J. Privacy Issues in Smartphone Applications: An Analysis of Headache/Migraine Applications. Headache. 2018 Jul 1;58(7):1014–27.

[9] Hill, A B. “The environment and disease : association or causartion ?” Proceedings of the Royal Society of Medicine vol. 58,5 (1965): 295-300.

[10] Ward AC. The role of causal criteria in causal inferences: Bradford Hill’s "aspects of association". Epidemiol Perspect Innov [Internet]. 2009 Jun 17 [cited 2018 Jun 26];6:2.

Troisième infographie

Heuristique de disponibilité / Rappel à la fréquence de base / Biais de représentativité / Biais de confirmation

Heuristique de disponibilité

Ce biais fait partie des plus fréquemment rencontrés dans « Cognitive biases associated with medical decisions : a systematic review » [1]. Il désigne la disposition à juger les événements comme étant plus probables, ou se produisant plus fréquemment, s’ils vous viennent facilement à l’esprit. Ainsi, l’expérience récente d’une maladie peut augmenter la probabilité qu’elle soit diagnostiquée. De plus, plus le diagnostic vous apparaîtra rapidement et évident, moins vous serez disposés à changer d’avis. Inversement, si une maladie n’a pas été observée depuis longtemps (est moins disponible), elle peut donc être sous-diagnostiquée [1].

C’est en 1991 que N. Schwarz fait une expérience [2] pour mettre en évidence cet heuristique.

Méthode : Des étudiants volontaires de l’université étaient séparés en deux groupes. Un premier groupe où ces élèves devaient raconter 6 expériences passées, où leurs capacités d’analyse, de réflexion, ou encore leur avis, avaient permis d’aboutir à un succès. Un second groupe avec la même consigne, mais pour 12 expériences. À la suite de cela, les étudiants devaient s’auto-évaluer sur leurs capacités à faire preuve d’intelligence et de bonnes capacités d’analyse.

Résultats : Les étudiants du premier groupe (6 expériences) se sont considérés comme étant dotés de bonnes capacités d’analyse, intelligents, et se trompant rarement. Cependant, les étudiants du second groupe (12 expériences) avaient une bien moins bonne image d’eux-mêmes. Ils se considéraient faisant partie de la moyenne sur ces critères de jugement.

Conclusions : D’après N. Schwarz, cette différence s’explique d’une part, par la difficulté à se rappeler de 12 expériences où l’on aurait fait preuve de bonnes capacités d’analyse. D’autre part, cette expérience montre que plus les infirmations sont facilement accessibles à notre mémoire, plus on aura tendance à s’y fier.

Oubli de la fréquence de base

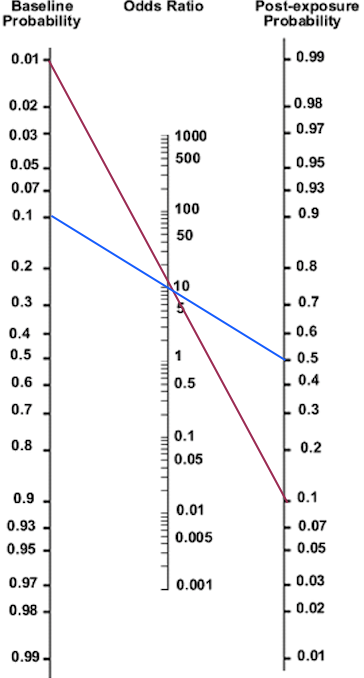

Ce biais cognitif conduit le praticien à oublier la probabilité de survenue d’un événement. Ce raisonnement est susceptible d’arriver par exemple, lorsque l’on utilise un test avec de bonnes valeurs clinimétriques, et de conclure sur la seule positivité/négativité du test, en oubliant la probabilité pré-test d’avoir cette pathologie [3].

Prenons un exemple pour illustrer ce biais :

Deux jeunes femmes arrivent à votre cabinet pour des douleurs dans le mollet et à l’arrière du genou, vous inspectez la jambe de votre patient : la zone est rouge et chaude comparativement au coté opposé. Vous suspectez une phlébite. La démonstration suivante va permettre d’illustrer qu’avec une même situation clinique, la fréquence de base d’une affection fera varier la probabilité d’avoir cette dite affection.

Imaginons qu’on ait à disposition un outil sensible et spécifique avec un ratio de vraisemblance positif à 10 évaluant la thrombose veineuse profonde (TVP) : le Phlébitomètre. Les deux patientes sont similaires en tous points, sauf qu’une des deux a accouché dans les 3 semaines précédentes. Les données épidémiologiques de la thrombose veineuse profonde montrent qu’une femme prenant une contraception de première catégorie a 1 risque sur 10 000 d’avoir une TVP [4], ce risque augmente d’un facteur 10 (1/1000) lors d’une grossesse ou pendant les 6 semaines post-accouchement [5].

Ici, la patiente prenant une contraception de première catégorie est représentée par la ligne rouge.

- Sa probabilité pré test est de 1% (ces probabilités pré-test ont été multipliées par 10 pour faciliter la lecture de ce nomogramme).

- On utilise le Phlébitomètre

- Sa probabilité post test d’avoir une phlébite est environ 10%

La ligne bleue représente la patiente dans les 3 semaines post-accouchement.

- Sa probabilité pré-test est donc de 10% .

- On utilise le Phlébitomètre

- Sa probabilité post-test d’avoir une thrombose veineuse profonde est de 50%.

On voit donc qu’avec une même situation clinique, la probabilité d‘avoir une pathologie dépend en partie de la prévalence de celle-ci.

Ancrage et représentativité

Dans « Cognitive biases associated with medical decisions : a systematic review » [1], l’ un des objectifs était de déterminer quels biais cognitifs étaient les plus responsables de mauvais diagnostics. Dans l’une des études incluses dans cette R.S [6], les auteurs ont procédé ainsi : en utilisant un système informatique pour visualiser et diagnostiquer des patients à partir de photos sur ordinateur (image d’affections cutanées). Un logiciel a enregistré les réponses des participants tout au long du processus de diagnostic, et les actions des participants automatiquement classées sur la base des définitions de huit heuristiques et/ou biais communs.

Dans cette étude mettant en scène 40 cas-scénario, les deux biais responsables de 51% des erreurs étaient le biais d’ancrage et le biais de représentativité. De plus, il n’y avait pas de différence significative entre les niveaux de formation des médecins et la fréquence de ces biais.

Biais de représentativité

Ce biais pousse le diagnosticien à chercher des manifestations typiques de la maladie : »Si ça ressemble à un canard, marche comme un canard, fait coin-coin comme un canard, alors c’est un canard. » Pourtant, le fait de limiter la prise de décision en fonction de ces modèles de reconnaissance conduit à passer à côté de variantes atypiques [1]. L’heuristique de représentativité a tendance à être insensible aux probabilités de pré-test et, par conséquent, néglige la prévalence. La restriction de la représentativité est l’erreur qui se produit lorsque la physiologie empêche de considérer un diagnostic particulier pour un patient, parce que ce dernier n’est pas suffisamment représentatif de la population. Le biais de représentativité se traduit par des diagnostics manqués ou non posés, principalement parce que certains aspects de la présentation du patient sont atypiques. [7].

Comment l’éviter ?

Selon Tversky A, Kahneman D. dans « Judgement under uncertainty: heuristics and biases. Science ». La prise de conscience de ces biais aide à les éviter [8] Cependant, on a vu précédemment que ce n’était pas si simple de par l’existence du biais de la tache aveugle. Lorsque les présentations des patients ne correspondent pas aux prototypes de la maladie, vous devez être conscients de la possibilité d’erreur, et vous rappeler des questions de prévalence [7].

Biais de confirmation

Le biais de confirmation est la tendance à chercher, à interpréter et à se souvenir de l’information qui correspond à nos attentes pré-existantes. De même, l’information qui contredit ces attentes peut être ignorée ou rejetée comme étant sans importance [9].

Recherche biaisée de l’information

- P. C. Wason (1960): On the failure to eliminate hypotheses in a conceptual task, Quarterly Journal of Experimental Psychology, 12:3, 129-140 : [10]

Cette expérience fut réalisée dans les années 1960 par le psychologue P. C. Wason. Son investigation cherchait à déterminer dans quelle mesure les jeunes adultes, qu’il considérait comme intelligents, font des déductions rationnelles sur des données qui ne suggèrent pas, a priori, une approche scientifique traditionnelle.

Méthode : 29 étudiants de premier cycle universitaire (11 première année, 12 deuxième année, 6 troisième année) en psychologie ont été évalué individuellement et ont reçu des instructions telles que :

« Vous allez recevoir une série de trois chiffres qui respecte une règle simple que j’ai à l’esprit. Cette règle concerne une relation entre ces trois nombres quelconques et non leur grandeur absolue, c’est-à-dire qu’il ne s’agit pas d’une règle comme tous les nombres supérieurs (ou inferieurs) à 50, etc. » L’objectif des étudiants était donc de découvrir cette règle à partir des séries de trois nombres qui respectaient la règle de la première série, en notant la raison pour chacune d’entre elles. Après avoir noté chaque série, un examinateur dira si les chiffres sélectionnés sont conformes ou non à la règle de départ. Lorsque les étudiants pensaient être sûrs d’avoir trouvé la règle, il devaient la communiquer à l’examinateur.

Résultats : 6 sujets sur les 29 ont identifié la règle du premier coup. Ces 6 individus, comparativement aux autres groupes, ont eu tendance à éliminer plus de possibilités et à donner lieu à plus d’arguments pour les séries ne respectant pas la règle de départ. 13 autres personnes ayant trouvé la règle après une tentative ont raisonné comme le premier groupe après s’être trompé. Pour tous les autres, les étudiants s’étant trompé au premier essai ne faisaient qu’énumérer des règles lorsqu’elles fonctionnaient avec une série. C’est-à-dire qu’ils ne prenaient en compte que les séries confirmant leurs hypothèses, et n’essayaient pas de les réfuter.

Conclusions : Les résultats de cette expérience montrent qu’une majorité d’individus semble plus facilement chercher des éléments confirmant leurs hypothèses, plutôt que d’essayer de les infirmer.

En pratique, cela peut nous arriver lorsque nous allons uniquement chercher à faire des tests ou poser des questions pour confirmer nos hypothèses diagnostiques. Il est utile de penser à essayer de confirmer d’autres hypothèses, et chercher à infirmer notre hypothèse principale.

Interprétation et mémoire biaisées de l’information

Forer B. R. The fallacy of personal validation : A classroom demonstration of gullibility. Journal of abnormal and social psychology, Vol 44, 1949, p. 118-123. [11]

Dans cette étude M. Forer, psychologue américain, a fait une expérience pour démontrer la tendance des gens à interpréter les choses comme cela les arrange et à voir des relations de cause à effet erronées.

Méthode : Des étudiants en psychologie devaient donner plusieurs éléments les concernant, tels que lieu et date de naissance à leur professeur, pour que celui-ci les transmette à un expert en astrologie. Plusieurs jours après, chaque élève recevait le même profil astrologique d’une dizaine d’items tels que :

« vous avez besoin d’être aimé et admiré »

« vous êtes critique avec vous-même »

« discipliné et maître de vous à l’extérieur, vous avez tendance à vous inquiéter et à manquer de confiance en vous à l’intérieur » …

Ensuite ces élèves devaient noter sur une échelle de 0 à 6 leur degré d’accord avec ces différentes prédictions.

Résultats : alors que tous les élèves avaient reçu le même profil, la majorité ont estimé à 4/5 la capacité de cette astrologue à dire la vérité sur eux grâce à leurs lieux et dates de naissance. Cette note de 4/5 était supérieure à la moyenne des items évalués individuellement. De plus, lorsqu’il leur était demandé de donner un exemple pour confirmer ou infirmer un item, les étudiants avaient plus de facilités à donner des exemples confirmant l’item s’il était bien évalué.

Conclusion : « La démarche de validation personnelle est susceptible de donner des résultats plus fallacieux dans le cas d’une évaluation globale d’un portrait de personnalité, que dans le cas d’une évaluation individuelle de déclarations spécifiques. »

Les cliniciens et autres personnes qui font des déductions sur les caractéristiques de leurs patients peuvent être amenés à attribuer un degré de signification excessivement élevé à ces déductions. Il est donc important que les cliniciens soumettent leurs propres procédures, présuppositions, et peut-être projections à une scrupuleuse vérification.

Comment l’éviter ?

Il est essentiel de rester constamment à l’affût de toute information qui pourrait contredire votre diagnostic actuel, et d’examiner attentivement toute information de ce genre, plutôt que de la rejeter comme étant non-pertinente. Il est également bon d’essayer de réfléchir aux raisons précises pour lesquelles votre théorie actuelle pourrait être fausse, et de poser des questions qui pourraient éventuellement réfuter votre hypothèse. Soyez toujours conscient des hypothèses alternatives, et demandez-vous si elles sont meilleures que vos idées actuelles. [9]

Références

[1] Saposnik et al. Cognitive biases associated with medical decisions: a systematic review. BMC Medical Informatics and Decision Making (2016) 16:138 DOI 10.1186/s12911-016-0377-1

[2] Schwarz, N. et al. (1991). Ease of Retrieval as Information: Another Look at the Availability Heuristic. Journal of Personality and Social Psychology, 61 (2), 195-202

[3] Thinking and Reasoning An Introduction to the Psychology of Reason, Judgment and Decision Making by Ken Manktelow

[4] Thrombose veineuse (Phlébite). (2015, novembre 7). Consulté à l’adresse https://www.inserm.fr/information-en-sante/dossiers-information/thrombose-veineuse-phlebite

[5] Heit JA, Kobbervig CE, James AH, et al. Trends in the incidence of venous thromboembolism during pregnancy or postpartum : A 30-year population-based study. Ann Intern Med 2005;143:697-706.

[6] Crowley, R. S., Legowski, E., Medvedeva, O., Reitmeyer, K., Tseytlin, E., Castine, M., Mello-Thoms, C. (2012). Automated detection of heuristics and biases among pathologists in a computer-based system. Advances in Health Sciences Education, 18(3), 343–363.

[7] Croskerry, P. (2002). Achieving Quality in Clinical Decision Making: Cognitive Strategies and Detection of Bias. Academic Emergency Medicine, 9(11), 1184–1204. doi:10.1197/aemj.9.11.1184

[8] Tversky A, Kahneman D. Judgement under uncertainty: heuristics and biases. Science. 1974; 186:1124–31.

[9] Klein, J. G. (2005). Five pitfalls in decisions about diagnosis and prescribing. BMJ, 330(7494), 781–783. doi:10.1136/bmj.330.7494.781

[10] P. C. Wason (1960): On the failure to eliminate hypotheses in a conceptual task, Quarterly Journal of Experimental Psychology, 12:3, 129-140

[11] Forer B. R. The fallacy of personal validation : A classroom demonstration of gullibility. Journal of abnormal and social psychology, Vol 44, 1949, p. 118-123

Quatrième infographie

Biais d’excès de confiance / Équipoise Clinique / Biais d’ancrage

Biais d’excès de confiance

Celui-ci désigne une tendance générale à croire que nous en savons plus qu’en réalité. L’excès de confiance reflète une tendance à agir sur la base d’informations incomplètes, d’intuitions ou de pressentiments. On fait trop confiance à l’opinion au lieu de recueillir des preuves avec soin [1]. Ce biais étant le plus fréquemment rencontré dans la revue systématique « Cognitive biases associated with medical decisions: a systematic review » [1].

Comment l’éviter ?

Selon une revue narrative publiée en 2013 sur le sujet « Cognitive debiasing 2: impediments to and strategies for change ». Une des solutions proposée par l’auteur était d’obtenir plus d’informations. Les heuristiques et les biais surviennent souvent dans le contexte d’une information insuffisante. La précision du diagnostic est liée à la rigueur de l’acquisition des données. Donc avec une prise d’informations structurées, en s’imposant une recherche volontaire de données, on peut éviter les » diagnostics spontanés « , en s’assurant que les symptômes moins évidents sont pris en compte.

Biais d’ancrage

Comme je l’ai dit précédemment, dans « Cognitive biases associated with medical decisions : a systematic review » [1] le biais d’ancrage est identifié comme l’un des deux biais étant responsables de 51% des erreurs.

L’ancrage est la tendance à se fixer sur les caractéristiques spécifiques d’une présentation trop tôt dans le processus de diagnostic, et à fonder la probabilité d’un événement particulier sur les informations disponibles au départ (c’est-à-dire la première impression obtenue lors de la première présentation). Cette stratégie peut souvent être efficace. Cependant, cette première impression exerce un effet trop puissant chez certaines personnes, et celles-ci ne parviennent pas à l’ajuster suffisamment à la lumière des informations ultérieures. L’ancrage peut être particulièrement dévastateur lorsqu’il est associé à un biais de confirmation, et peut conduire à une réflexion fermée prématurément. Les patients peuvent être étiquetés avec un diagnostic incorrect très tôt dans leur présentation. Une fois qu’une étiquette est posée sur un patient, il est difficile de l’enlever [2].

Comment l’éviter ?

La prise de conscience de la tendance à l’ancrage est importante. Il convient d’éviter les suppositions précoces. Dans la mesure du possible, retardez la prise de décision jusqu’à ce que des informations plus complètes soient disponibles. [2]

Équipoise clinique ou principe d’incertitude

Le terme d’équipoise personnelle est utilisé pour désigner une absence de préférence de moyen thérapeutique chez des praticiens. En l’absence d’équipoise, une préférence marquée d’un praticien pour une technique particulière influencera l’effet de celle-ci. Un véritable état d’equipoise existe lorsque l’on ne dispose d’aucune base solide pour choisir entre deux ou plusieurs options de soins [3].

L’équipoise clinique est un concept plutôt lié à la recherche, et a également été appelé état/principe d’incertitude [4]. Tout comme l’équipoise clinique, l’équipoise personnel existe lorsque le clinicien participant à l’étude de recherche n’a aucune préférence, ou est véritablement incertain quant au bénéfice ou au préjudice global offert par le traitement à son patient [3].

Les préférences personnelles préconçues associées à une intervention, qu’elle soit bonne ou mauvaise, sont probablement toujours présentes. Par conséquent, on peut se demander si un environnement peut exister dans un état d’équipoise complet [3].

Comment l’éviter ?

Comme il est peu probable qu’un praticien n’ait pas de préférence, la non-équipoise personnelle est sûrement inévitable. Toutefois, limiter les tests non-prescriptifs (ceux qui n’ont pas d’influence sur la suite du traitement), pour ne pas enfermer le patient dans un cadre, pourrait permettre de conserver l’étendue de ses options thérapeutiques.

Références

[1] Saposnik et al. Cognitive biases associated with medical decisions: a systematic review. BMC Medical Informatics and Decision Making (2016) 16:138 DOI 10.1186/s12911-016-0377-1

[2]Croskerry, P. (2002). Achieving Quality in Clinical Decision Making: Cognitive Strategies and Detection of Bias. Academic Emergency Medicine, 9(11), 1184–1204. doi:10.1197/aemj.9.11.1184

[3] Cook, C, Sheets, C. Clinical equipoise and personal equipoise: two necessary ingredients for reducing bias in manual therapy trials. J Man Manip Ther. 2011;19(1):55–57.

[4] Fries J, Krishnan E. Equipoise, design bias, and randomized controlled trials: the elusive ethics of new drug development. Arthritis Care Res 2004;6:250–5.

Cinquième infographie

Biais de sélection / Biais du survivant / Biais d’attribution / Effet de cadrage

Biais de sélection

Le biais de sélection est une erreur méthodologique de sélection de l’échantillon. Il est donc probable que l’échantillon étudié ne soit pas du tout représentatif de la population générale rencontrée habituellement. En cabinet, ce biais pourrait arriver lors de la conclusion d’être un bon thérapeute parce que tous les patients qui reviennent sont satisfaits de leurs traitements, cependant ceux qui ne reviennent pas ne sont pas pris en compte.[1]

Biais du survivant

Ce biais cognitif consiste à surévaluer l’effet d’un traitement par la seule prise en compte des exceptions (les survivants, ou les « hors normes » ayant répondu favorablement), et non d’un échantillon représentatif. Ce biais est donc une forme de biais de sélection [2].

Un exemple connu qui ne concerne en rien le milieu de la santé est celui des bombardiers de l’US Air Force pendant la seconde guerre mondiale. L’armée de l’air américaine cherchait désespérément un moyen de donner à ses pilotes une meilleure chance de rentrer chez eux en toute sécurité, et s’est donc tournée vers le statisticien Abraham Wald. Les ingénieurs avaient besoin de lui pour leur dire où exactement ils devaient mettre un blindage supplémentaire dans l’avion. Quand on regarde les bombardiers qui ont réussi à rentrer chez eux, les trous de balles se trouvent principalement autour du centre de l’avion et des ailes. L’armée de l’air pensait qu’ils devaient mettre le blindage sur ces zones, mais Wald a montré que cette stratégie ne fonctionnerait pas. Selon lui, les endroits où il y avait des trous de balles étaient des endroits où un bombardier pouvait être abattu et survivre au vol de retour. Les endroits où il n’y avait pas de dégâts étaient ceux qui nécessitaient des protections supplémentaires, comme le moteur par exemple [2].

En général, le biais du survivant joue un rôle énorme en médecine, que ce soit dans les études ou dans une clinique réelle. Il est toujours important de noter la présence d’un biais du survivant afin de pouvoir en rendre compte à la fin de la journée. Souvent, ce biais est extrêmement difficile à découvrir, car il nécessite de prendre assez de recul sur une situation afin de s’en rendre compte. Cela renforce la nécessité pour les cliniciens comme nous et les chercheurs d’être à l’affût de ces biais, afin d’arriver à une meilleure compréhension des maladies, et à de meilleurs résultats pour les patients. Éléments qui peuvent toujours être améliorés [2].

Biais d’attribution ou erreur fondamentale d’attribution

L’erreur fondamentale d’attribution est la tendance à croire que le comportement des autres personnes est principalement déterminé par leur caractère et leurs traits de personnalité, plutôt que par les circonstances. Elle nous conduit à minimiser les effets contextuels d’une thérapie par rapport à son effet propre [3].

Parfois, l’erreur d’attribution conduit les personnes à supposer des caractéristiques positives chez les autres. À d’autres moments, l’erreur fondamentale d’attribution conduit ces mêmes personnes à présumer des caractéristiques négatives des autres. Dans le pire des cas, il s’agit d’une forme de blâme de la victime, où les personnes malades et celles qui se trouvent dans des circonstances malheureuses sont tenues pour responsables du sort qui leur est réservé. En particulier, les patients souffrant de troubles chroniques ont tendance à souffrir de ce préjugé [3].

Comment l’éviter ?

Ce biais engendre parfois des comportements ayant pour conséquences de blâmer les patients en les considérant responsables de leur situation. Le fait d’essayer d’éviter les biais d’attribution ne signifie pas que les soignants doivent considérer les patients comme des victimes impuissantes de leur situation et/ou de leur génétique… Qu’ils soient incapables d’apporter des changements pour améliorer leur santé. Le fait d’éviter les biais d’attribution ne signifie pas non plus que les soignants doivent éviter de conseiller les patients sur leurs comportements à risque par crainte de porter un jugement sur eux.

Par exemple, les fumeurs doivent être informés de la façon dont ce comportement met leur santé en danger et doivent être encouragés à arrêter. Les personnes sédentaires doivent être encouragées à faire de l’exercice. Il convient d’informer les personnes en surpoids (qui ne sont pas nécessairement sédentaires) des risques que l’obésité fait peser sur leur santé. Toutefois, tout cela doit être fait de manière à les soutenir et à ne pas les juger [3].

Le simple fait de dire aux gens de perdre du poids et d’arrêter de fumer, sans soutien ni ressources supplémentaires, a peu de chance d’être efficace. Jackson, S. et ses collègues ont étudié 2 944 personnes et ont constaté que les personnes se sentant victimes de jugement (pouvant être l’expression d’un biais d’attribution) en matière de poids finissaient par prendre plus de poids [4].

Il faut garder à l’esprit qu’un patient qui aurait un comportement inadapté en rapport avec sa pathologie devra en assumer les conséquences. Suggérer le contraire reviendrait à infantiliser le patient. Cependant, il serait raisonnable de considérer qu’il y a une explication au comportement de ce patient. Un patient présentant des douleurs persistantes et n’effectuant pas une activité physique quotidienne n’implique pas forcément de la mauvaise volonté. Il est possible que ce patient n’ait pas compris l’intérêt de l’activité physique, ou ait peur d’aggraver ses symptômes. Dans ce cas, ce comportement est rationnel pour lui, et c’est aux soignants d’identifier les causes pour en trouver les solutions.

Effet de cadrage

Ce biais désigne la tendance à tirer des conclusions différentes d’une même information, en fonction de la manière dont cette information est présentée [1]. Ce biais a été découvert la première fois par Kahneman D. est ses collègues en 1881 avec cette expérience [5] :

Deux groupes de personnes devaient se prononcer sur l’utilisation d’un traitement A ou B pour soigner un virus. Dans le premier groupe, on a donné le choix entre ces deux traitements :

– Un traitement A qui sauvera 200 personnes

– Un traitement B qui a 1 chance sur 3 de sauver les 600 malades mais aussi 2/3 de risque de ne sauver personne.

En fait, les deux traitements ont la même probabilité de sauver 200 personnes, ils sont juste présentés différemment. Cependant, 72% des individus du groupe ont choisi le traitement A, car le traitement B avait une forte probabilité de ne sauver personne selon eux.

Dans le second groupe, le même procédé a été utilisé, mais avec une formulation différente :

– L’option A provoque la mort de 400 malades

– L’option B a 33% de chance que tout le monde survive et 66% de risque que tout le monde meure.

Ici encore les probabilités sont les mêmes, néanmoins le groupe 2 a choisi à quasiment 80% l’option B.

On remarque bien avec cette expérience que la formulation de l’information influe la réponse, un peu à la manière d’un wording effect mentionné plus haut.

Dans une pratique quotidienne, un patient arrive avec une ordonnance. Dans ce cas, le diagnostic médical peut avoir un effet de cadrage sur votre prise en charge. Un autre exemple, lorsque le patient vous décrit la raison de son problème, l’ordre dans lequel il va vous énoncer les symptômes, les mécanismes d’apparition… Peuvent avoir ce même effet de cadrage sur votre diagnostic kinésithérapique, et donc influencer votre traitement.

Pour finir, lors de l’examen clinique, il est possible que l’utilisation de tests non-prescriptifs enferme le patient dans des cases, empêchant l’utilisation de certains traitements potentiellement efficaces.

Références

[1] Saposnik et al. Cognitive biases associated with medical decisions: a systematic review. BMC Medical Informatics and Decision Making (2016) 16:138 DOI 10.1186/s12911-016-0377-1

[2] Bajaj, S. (2019, septembre 30). Survivorship Bias in Medicine. Consulté à l’adresse https://doctorinprogress.com/2018/01/21/survivorship-bias-in-medicine/?locale=en

[3] Howar, J. Attribution Biases: The Fundamental Attribution Error and Self-Serving Bias in : Cognitive Errors and Diagnostic Mistakes: A Case-Based Guide to Critical. Springer International Publishing. 1st ed. 2019. P 183 – 187.

[4] Jackson SE, Beeken RJ, Wardle J. Perceived weight discrimination and changes in weight, waist circumference, and weight status. Obesity. 2014;22(12):2485–8. https://doi.org/10.1002/ oby.20891.

[5] Tversky, A., & Kahneman, D. (1981). The framing of decisions and the psychology of choice. Science, 211(4481), 453–458. doi:10.1126/science.7455683

One Comment

matthieu catteau

tres interressant